La relation d’OpenAI au travail de ses employés comme des entraîneurs de données, celle de Sam Altman à la consommation énergétique de son entreprise, la manière dont l’industrie freine la recherche scientifique en IA… Next a parlé de tous ces sujets avec la journaliste et autrice d’« Empire of AI » Karen Hao. En 2015, une dizaine […]

Le philosophe Rob Horning rapporte que des chercheurs de Google ont publié un article décrivant un projet de « Machines d’Habermas » – hommage au philosophe et à sa théorie de l’espace public – décrivant des machines permettant de faciliter la délibération démocratique. L’idée consiste à utiliser des IA génératives pour générer des déclarations de groupes à partir d’opinions individuelles, en maximisant l’approbation collective par itération successive. Le but : trouver des terrains d’entente sur des sujets clivants, avec une IA qui fonctionne comme un médiateur.

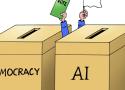

La perspective que dessinent les ingénieurs de Google consiste à court-circuiter le processus démocratique lui-même. Leur proposition vise à réduire la politique en un simple processus d’optimisation et de résolution de problèmes. La médiation par la machine vise clairement à évacuer la conflictualité, au cœur de la politique. Elle permet d’améliorer le contrôle social, au détriment de l’action collective ou de l’engagement, puisque ceux-ci sont de fait évacués par le rejet du conflit. Une politique sans passion ni conviction, où les citoyens eux-mêmes sont finalement évacués. La démocratie est réduite à une simple mécanique de décisions, sans plus aucune participation active.

À chaque étape de l’émergence de l’État artificiel, les leaders technologiques ont promis que les derniers outils seraient bons pour la démocratie… mais ce n’est pas ce qui s’est passé, notamment parce qu’aucun de ces outils ne sont démocratiques. Au contraire, le principal pouvoir de ces outils, de Facebook à X, est d’abord d’offrir aux entreprises un contrôle sans précédent de la parole, leur permettant de moduler tout ce à quoi l’usager accède.

Dans la cacophonie médiatique comme dans le fond des sujets, l’appréhension et la hiérarchisation des risques de l’intelligence artificielle vise souvent à côté, et les réponses aux antédiluviennes questions sur les dégâts du progrès sont toujours attendues. Nous souhaitons avec ce texte, réarmer le débat sur l’IA en portant l’attention – un peu arbitrairement peut-être – sur quatre angles morts qui le polluent actuellement.

De manière générale, les médias commentent les percées technologiques (souvent très relatives) et le développement économique, au détriment des questions sociales et éthiques. Et lorsque celles-ci surgissent, elles puisent le plus souvent dans un répertoire de références populaires issues de la science-fiction.

C’est là un autre point aveugle dans le débat sur les risques de l’IA : la qualité de la négociation locale à propos de la légitimité de son déploiement et, le cas échéant, ses modes de diffusion au sein des entreprises.

C’est une nouvelle règle du jeu dans l’univers de la politique à l’ère numérique : un flot continu de contenus générés artificiellement caractérise désormais les campagnes électorales, avec l’essor d’outils gratuits, comme le clonage des voix ou l’édition d’images.

Au Pakistan, les dernières législatives [en 2018] témoignaient déjà d’une sophistication croissante des campagnes numériques : création de faux comptes, bombardements coordonnés de hashtags, applis mobiles personnalisées, organisation de grands événements à partir des réseaux sociaux… Et, en février 2024, le pays va vivre sa plus grande élection dématérialisée. Les partis politiques sont naturellement tentés de franchir un nouveau cap avec l’intelligence artificielle [IA].

Si les IA et les logiques algorithmiques des grandes plateformes peuvent intervenir sur le débat public, les tensions qui traversent les processus de délibération ne naissent pas forcément du numérique. C’est ce que développe Salomé Frémineur, chargée de cours invitée en philosophie à l’ULB, l’UMONS et à l’Université de Namur qui étudie le rôle du langage dans la politique. Elle s’est notamment penchée sur les processus de délibération et sur ce qui pouvait fonder et animer des espaces de discussions publiques. Comment les IA (et les fantasmes qu’on peut nourrir sur elles) travaillent-elles des processus démocratiques ?

Antoinette Rouvroy, philosophe et chercheuse en droit à l’Université de Namur, étudie de longue date les enjeux politiques et sociaux des algorithmes. Nous lui avons demandé de quelle manière les systèmes d’intelligences artificielles (IA) travaillaient et transformaient actuellement nos démocraties. Et le danger des algorithmes, ou plutôt du « capitalisme sous stéroïde algorithmique », ne semble pas tant celui de perturber l’information des citoyen·nes ou même les élections. Mais, en flattant notre hyperindividualisme, ces processus nous fragmentent et court-circuitent ce qui fonde même les démocraties : le besoin et le désir de commun. Un moment constitutionnel pourrait bien constituer l’antidote à cette colonisation des esprits par le numérique marchand.

On ne peut pas comprendre le développement phénoménal des algorithmes aujourd’hui sans saisir les reconfigurations du capitalisme de ces 20 dernières années. C’est ce que montrent deux enseignant-chercheurs, Jonathan Martineau et Jonathan Durand Folco, respectivement à l’Université Concordia (Montréal) et à l’Université de Saint-Paul (Ottawa) dans "Le capital algorithmique".

Ce livre développe en 20 thèses de quoi réfléchir de manière puissante, critique et multidimensionnelle les logiques algorithmiques et les intelligences artificielles qui bouleversent nos vies actuellement, le plus souvent au profit du marché. Selon eux, les changements techniques, économiques, sociaux et politiques sont tels que nous sommes passés à une nouvelle phase du capitalisme. Celui-ci, devenu algorithmique, affecte de multiples sphères de la société. Dont le fonctionnement de nos démocraties.